LLMのトークン生成確率で起きる矛盾について

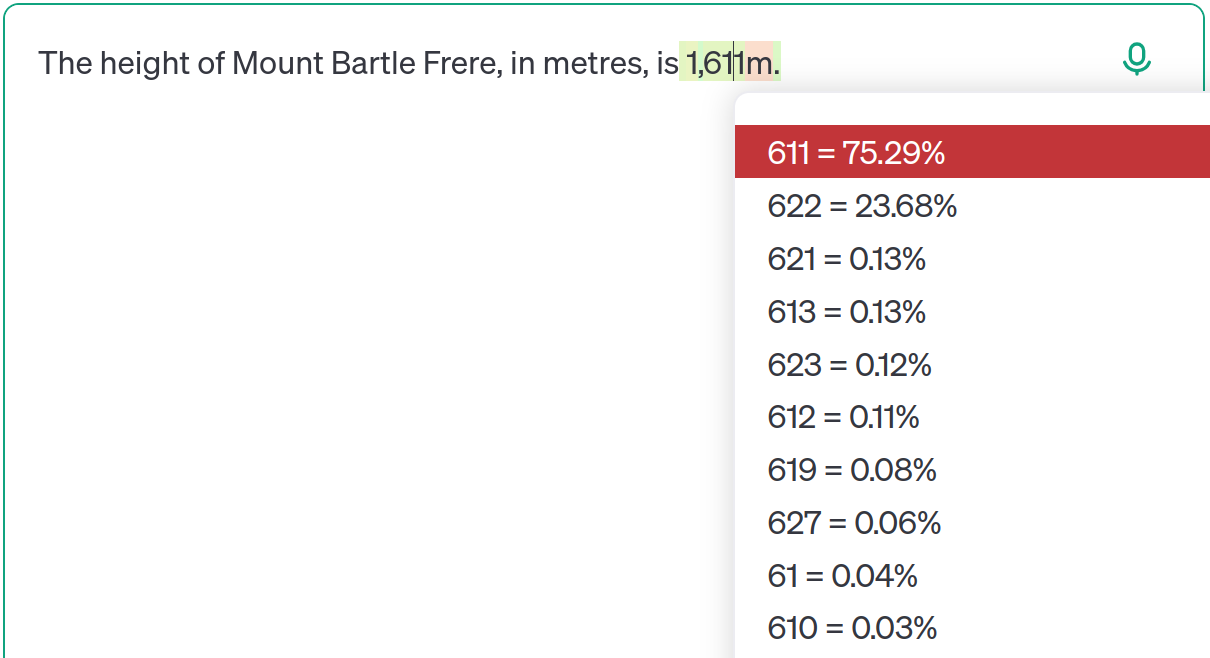

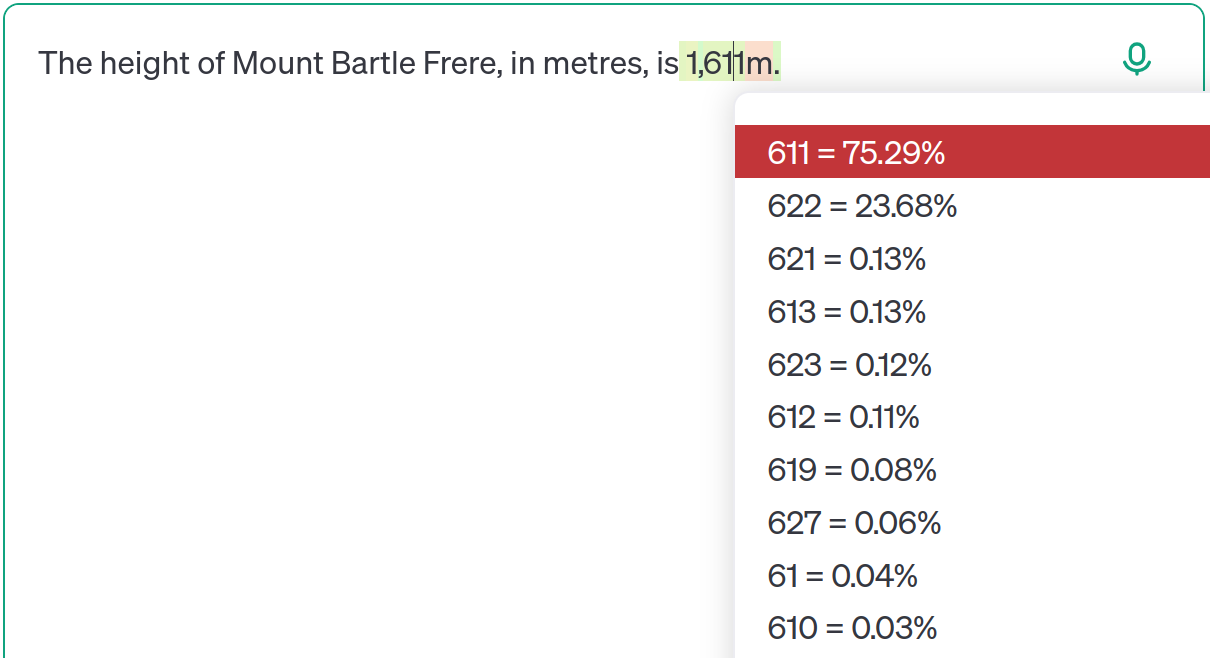

How outdated information hides in LLM token generation probabilities and creates logical inconsistencies

Random tech notes

1: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:34:56.78 ID:KqQbZV9V0

ゴミを入れればゴミが出る

2: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:35:56.78 ID:kidney-beans

>>1

そうだけど、OpenAIはトレーニングデータの詳細とか非公開だから、ランダムにゴミが混ざって、それが賞品扱いされる感じだよな。

3: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:36:56.78 ID:KqQbZV9V0

>>2

それな!ユーザーが内部の仕組み全部わかってるわけじゃないのに使うのも問題だよな。

4: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:37:56.78 ID:KqQbZV9V0

授業中に先生が質問してきて、答えわかんないけど適当にそれっぽいこと言うのに似てるよね。

5: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:38:56.78 ID:KqQbZV9V0

AIのバグとかは最終的には治ると思うけどね。

6: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:39:56.78 ID:KqQbZV9V0

>>5

いやいや、そういう問題じゃなくて根本的な仕組みの違いだから、ツールや設計を変えないと無理じゃね?

7: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:40:56.78 ID:kidney-beans

>>5

ブログの例でLLMの限界指摘してるのあるけど、根本的な動作の問題だから修正は簡単じゃないと思うよ。

8: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:41:56.78 ID:KqQbZV9V0

>>7

LLMはデータエンコードじゃなくて思考生成に特化すべきだよな。

9: 以下、名無しにかわりましてVIPがお送りします 2025/01/10(金) 12:42:56.78 ID:kidney-beans

>>7

外部データと組み合わせて使えば良いけど、古い内部知識が邪魔するのは避けられないよね。

元スレ

How outdated information hides in LLM token generation probabilities and creates logical inconsistencies

byu/kidney-beans inprogramming

コメント